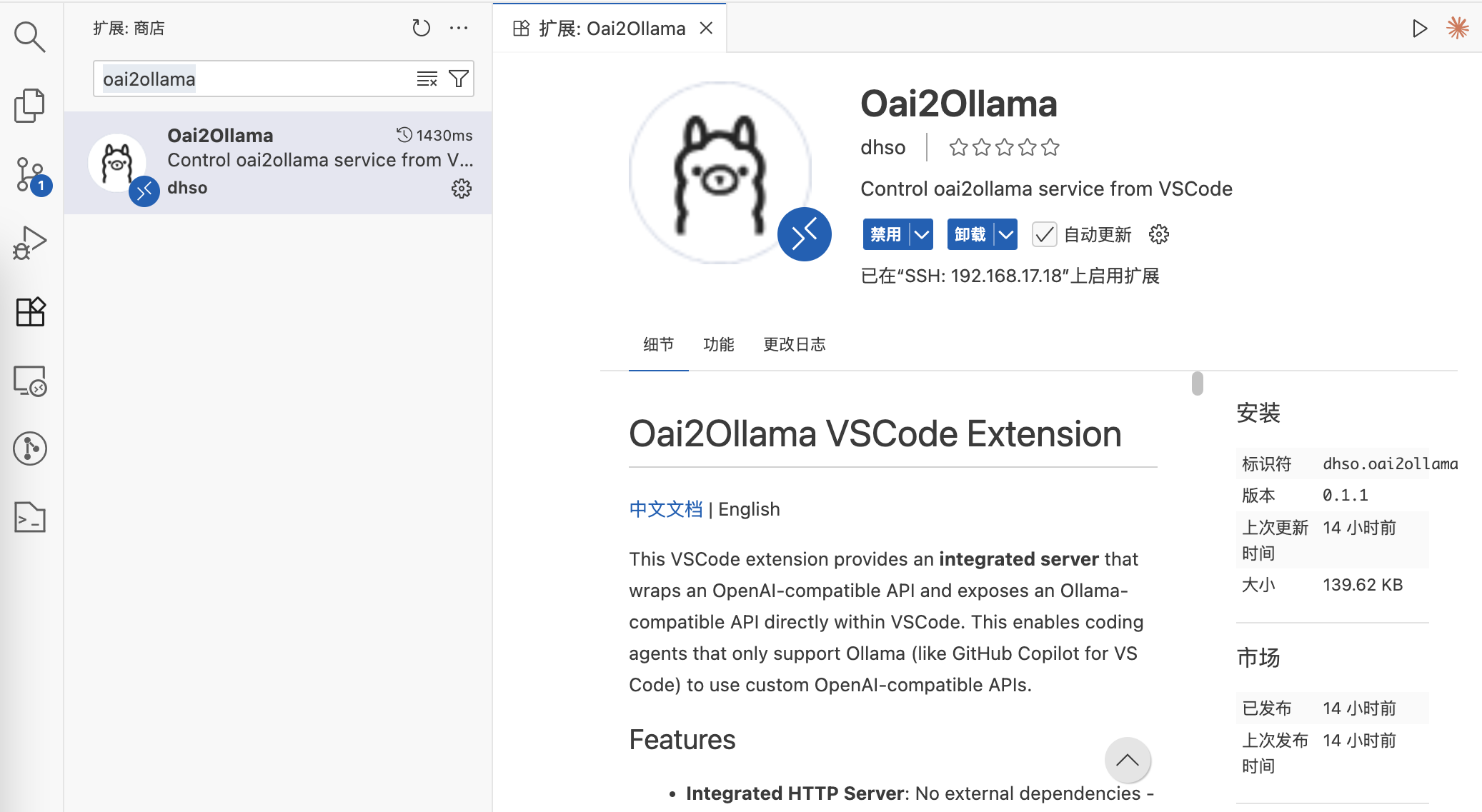

Oai2Ollama 是一个 基于 oai2ollama 实现的 VSCode 插件,提供集成的 HTTP 服务器,将 OpenAI 兼容的 API 封装并暴露为 Ollama 兼容的 API。这使得只支持 Ollama 的编程助手(如 VSCode 中的 GitHub Copilot)能够使用自定义的 OpenAI 兼容 API。

功能特性

- 集成 HTTP 服务器:无需外部依赖 - 服务器直接在插件中运行

- 启动/停止/重启服务:使用简单命令控制服务

- 端口占用检测:自动检测并处理端口冲突

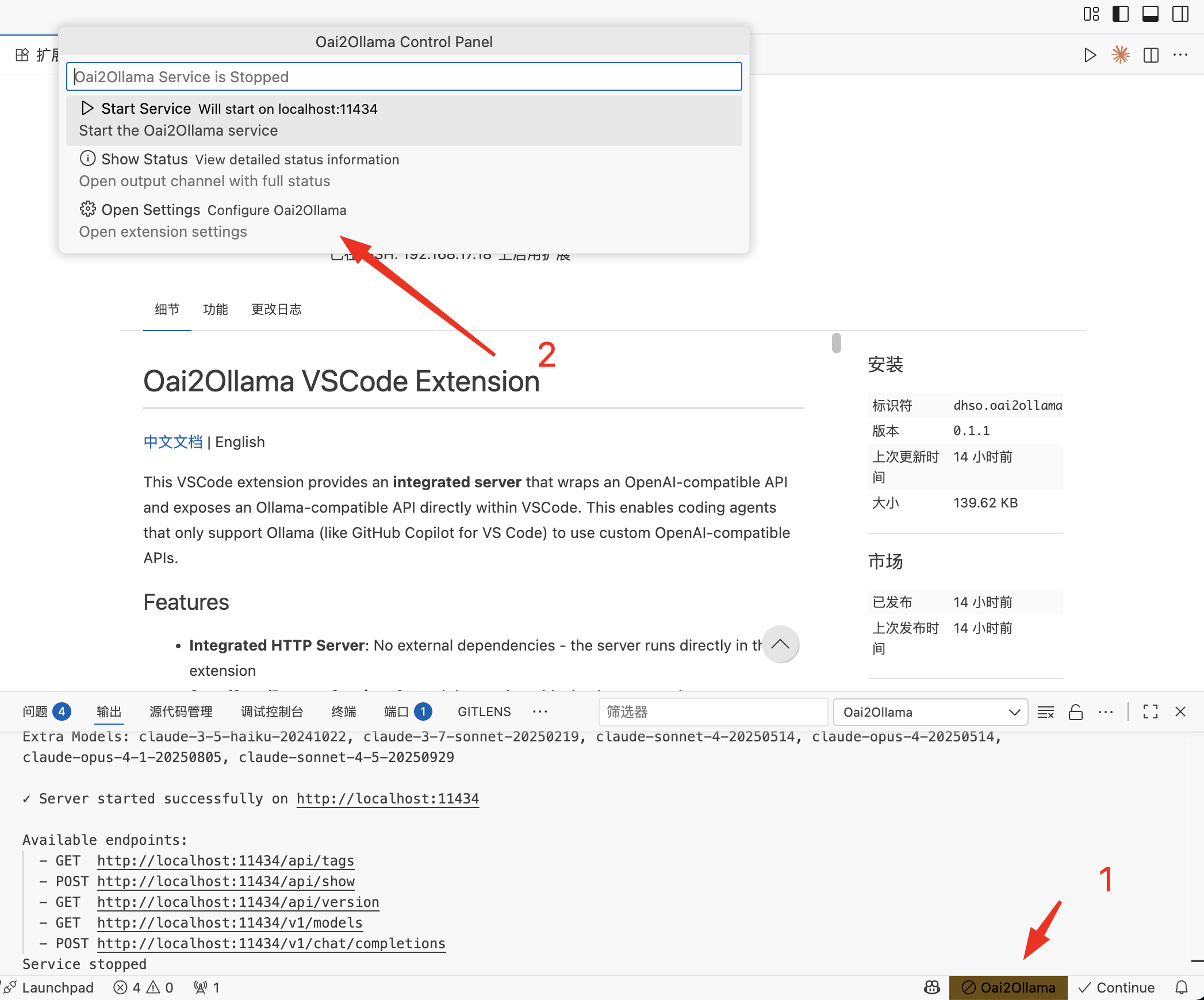

- 状态栏集成:在状态栏一目了然地查看服务状态

- 配置管理:通过 VSCode 设置配置所有选项

- 自动启动:可选择在 VSCode 启动时自动启动服务

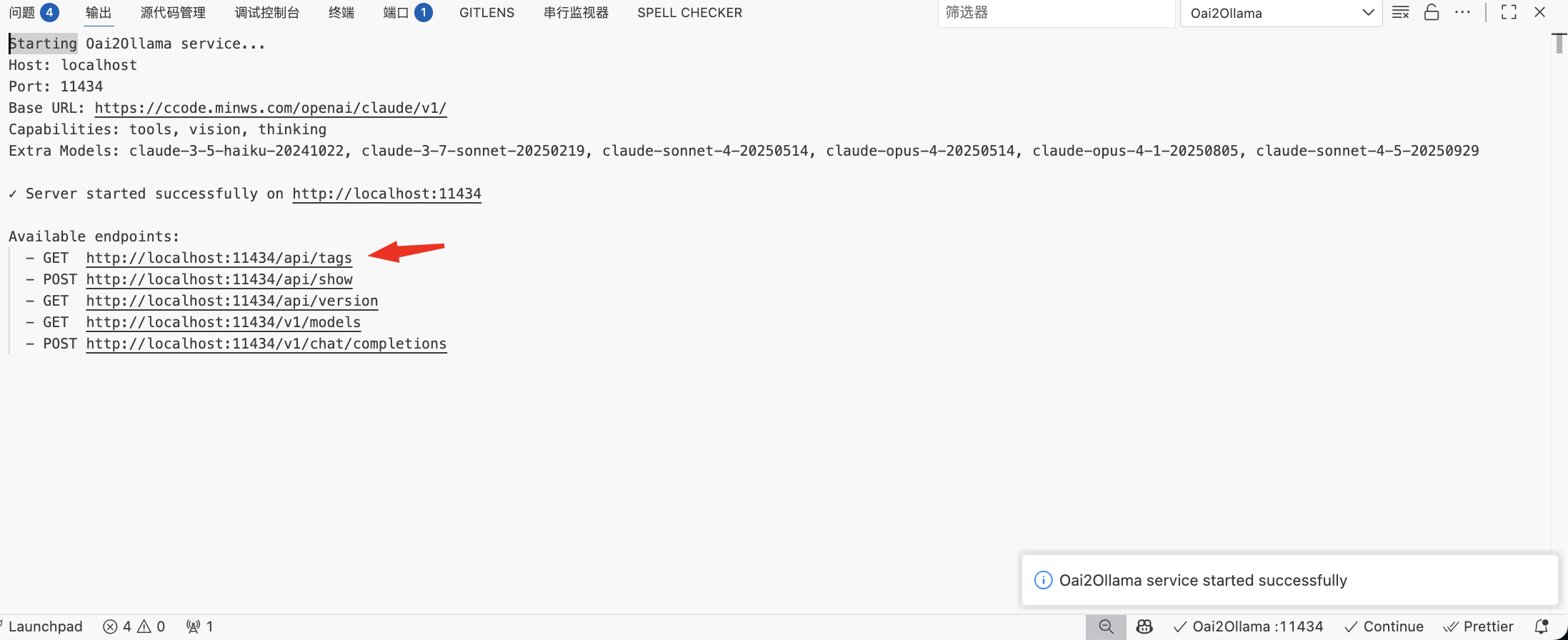

- 输出通道:在专用输出通道查看服务日志和请求

- 完整 API 兼容性:实现了 Ollama 和 OpenAI v1 端点

系统要求

无需外部依赖! 插件包含了实现所有 oai2ollama 功能的内置 HTTP 服务器。

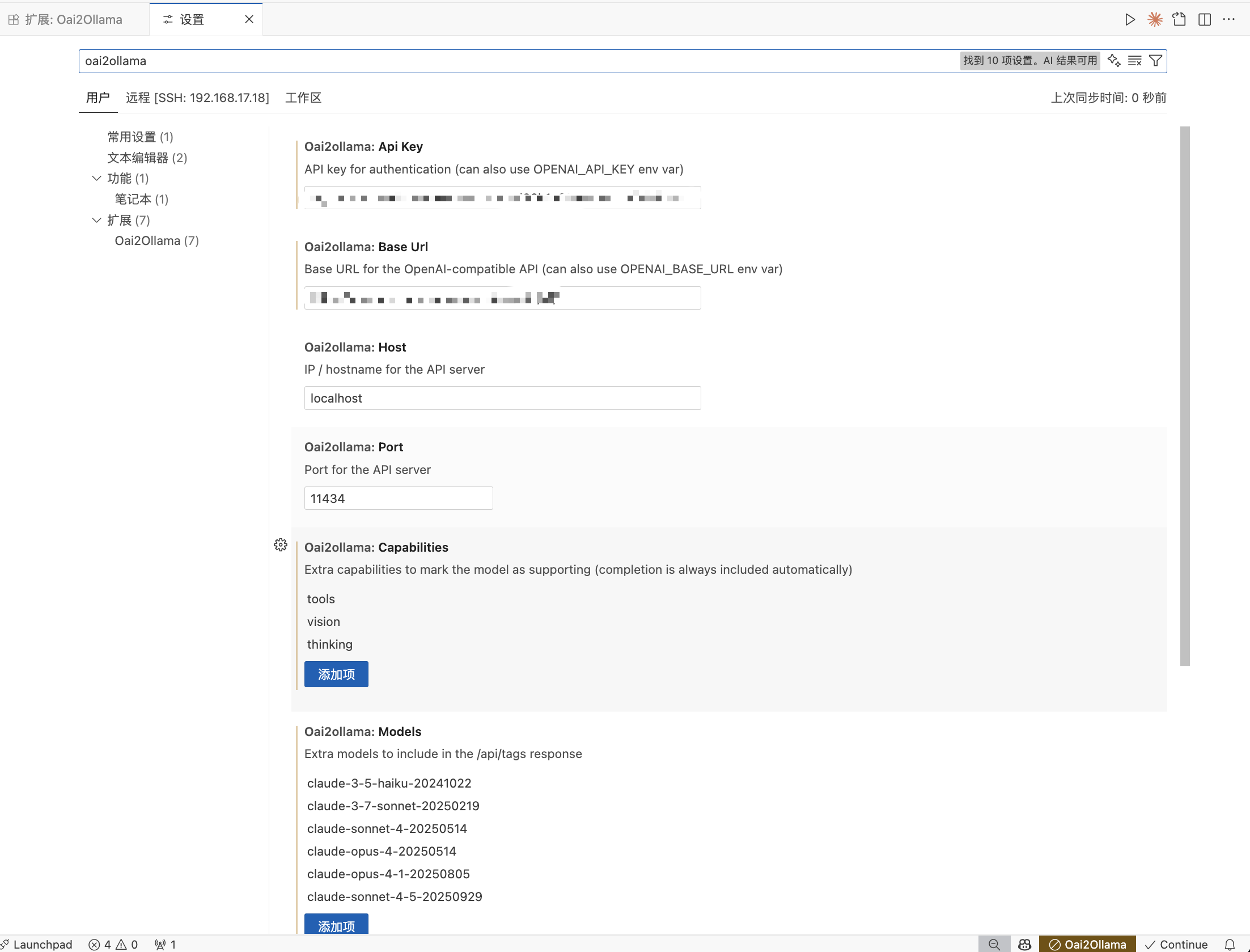

配置项

必需配置

- oai2ollama.apiKey:用于身份验证的 API 密钥(或设置 OPENAI_API_KEY 环境变量)

- oai2ollama.baseUrl:OpenAI 兼容 API 的基础 URL(或设置 OPENAI_BASE_URL 环境变量)

可选配置

- oai2ollama.host:API 服务器的 IP/主机名(默认:localhost)

- oai2ollama.port:API 服务器的端口(默认:11434)

oai2ollama.capabilities:标记模型支持的额外能力

- 可选项:tools、insert、vision、embedding、thinking、completion

- 注意:completion 能力总是自动包含,即使不指定

- 这些与 Ollama 当前使用的能力匹配

- 查看 CAPABILITIES.md 了解详细说明和示例

- oai2ollama.models:在 /api/tags 响应中包含的额外模型

适用于上游 /models 端点未返回的模型

- oai2ollama.autoStart:VSCode 启动时自动启动服务(默认:false)

快速配置

{

"oai2ollama.apiKey": "your_apikey",

"oai2ollama.baseUrl": "https://your_openai_url/v1/",

"oai2ollama.capabilities": [

"tools",

"vision",

"thinking"

],

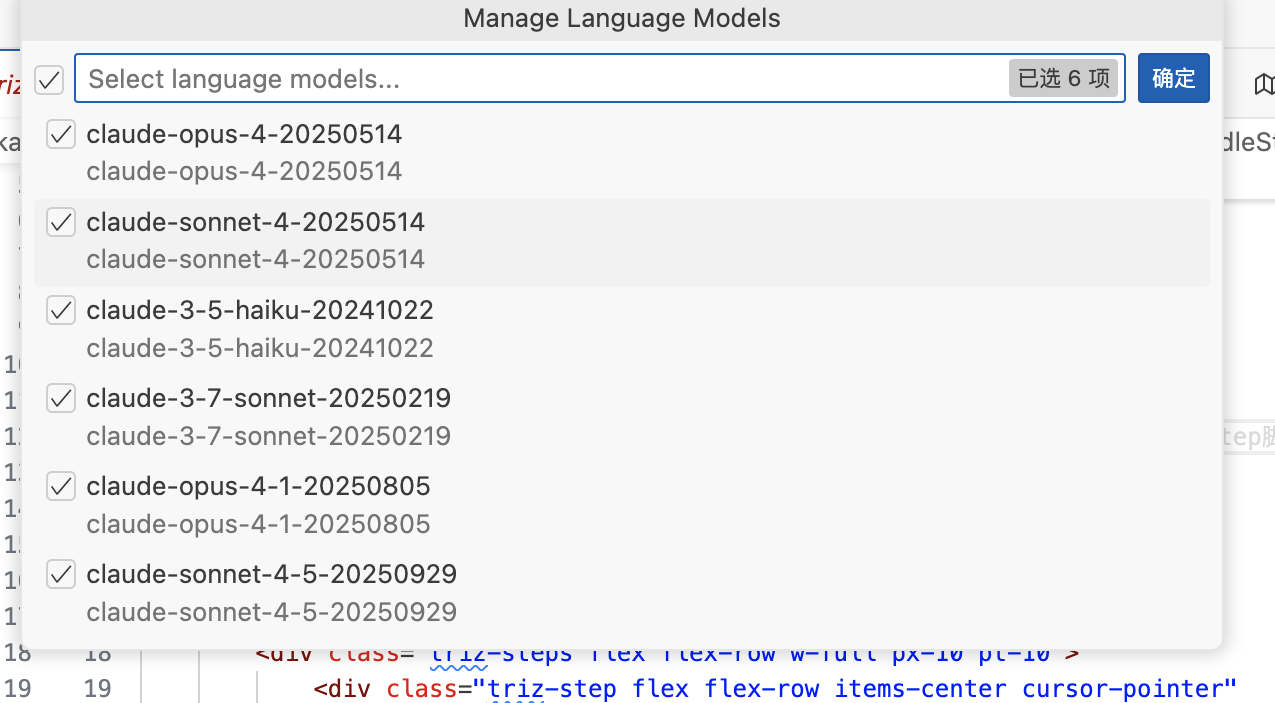

"oai2ollama.models": [

"claude-3-5-haiku-20241022",

"claude-3-7-sonnet-20250219",

"claude-sonnet-4-20250514",

"claude-opus-4-20250514",

"claude-opus-4-1-20250805",

"claude-sonnet-4-5-20250929"

]

}命令

从命令面板(Ctrl+Shift+P / Cmd+Shift+P)访问这些命令:

Oai2Ollama: Start Service - 启动集成服务器

Oai2Ollama: Stop Service - 停止运行的服务器

Oai2Ollama: Restart Service - 重启服务器

Oai2Ollama: Show Status - 显示详细的服务状态和可用端点

Oai2Ollama: Open Settings - 打开插件设置使用方法

初始设置

- 安装插件

oai2ollama

- 点击底部状态栏插件设置,打开设置

- 配置你的 API 密钥和基础 URL

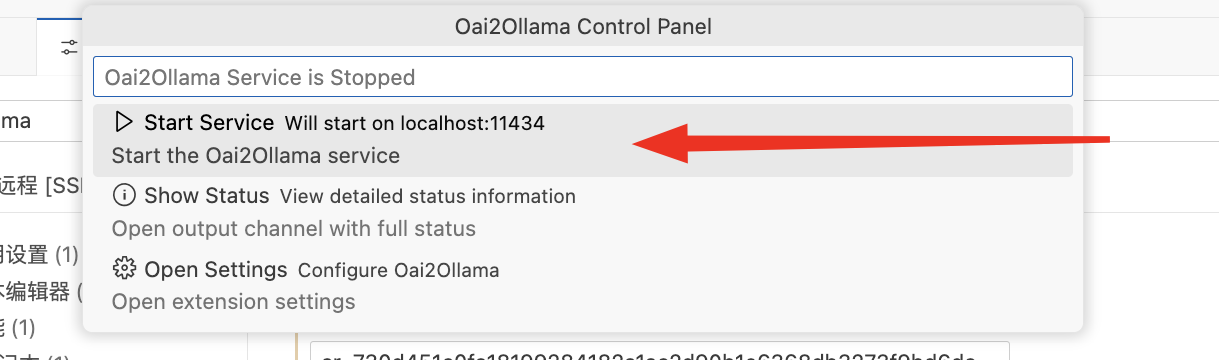

- 使用 Oai2Ollama: Start Service 命令启动服务

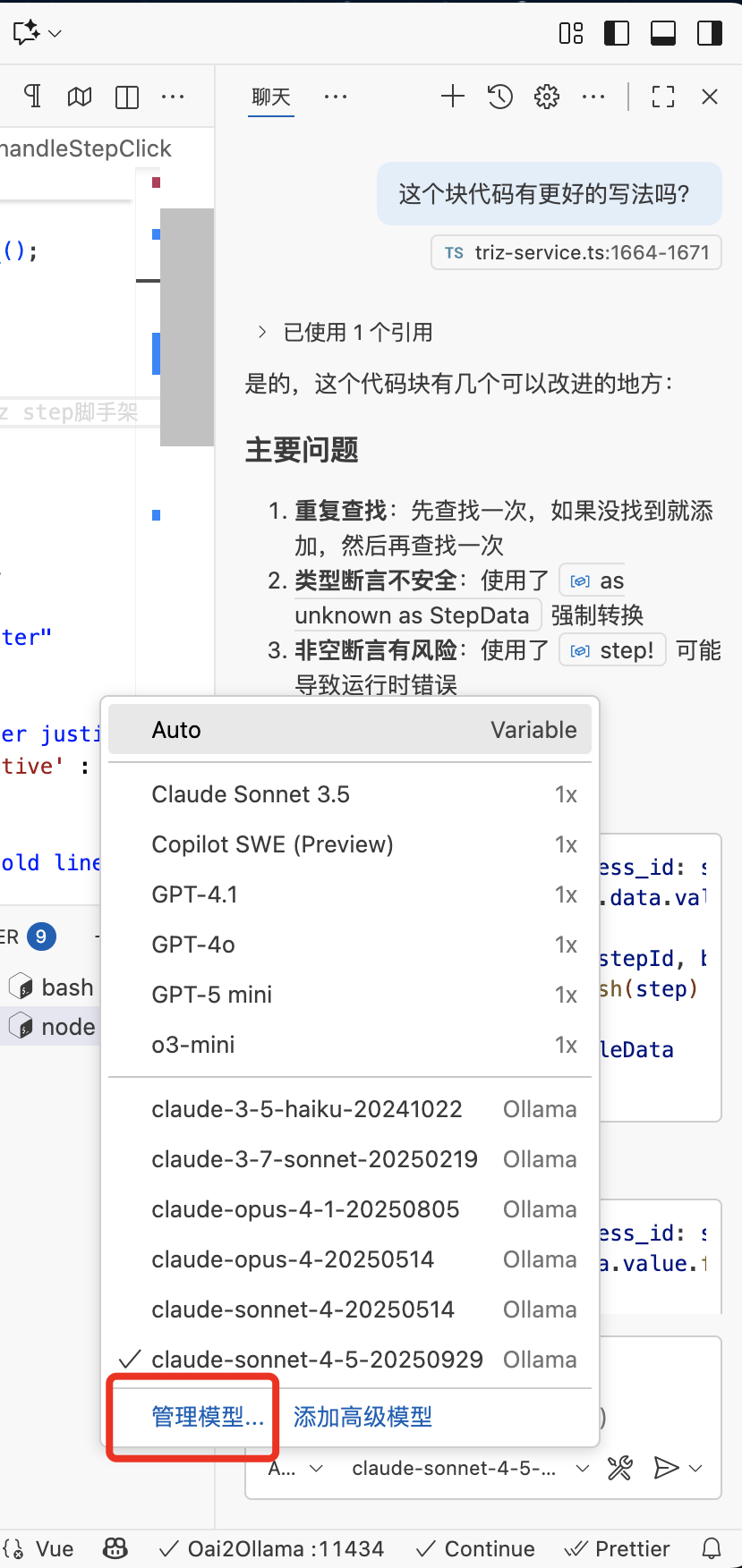

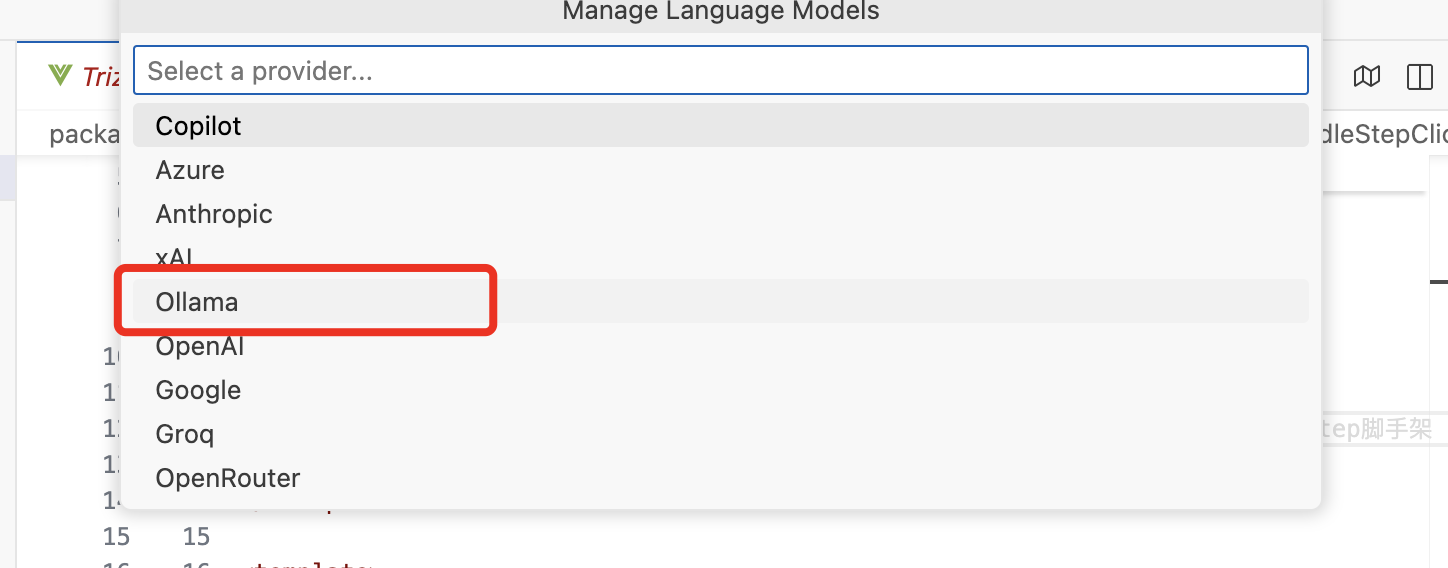

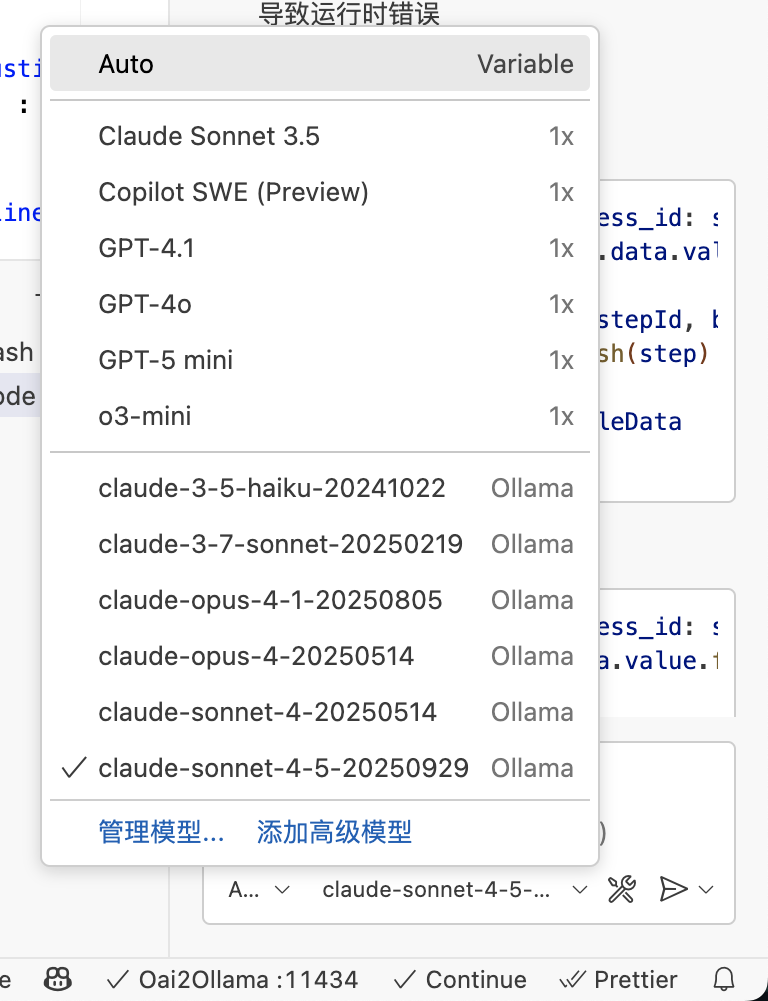

- 管理copilot模型

- 选择

ollama

- 添加模型

- 成功

状态栏

状态栏显示当前服务状态:

- ✓ Oai2Ollama :11434 - 服务正在端口 11434 上运行

- ⊘ Oai2Ollama - 服务已停止(警告背景)

点击状态栏项目可打开快速操作菜单,提供以下选项:

- 启动服务(停止时显示)

- 停止服务(运行时显示)

- 重启服务(运行时显示)

- 显示状态 - 查看详细状态信息

- 打开设置 - 配置插件

无需使用命令面板,即可快速访问所有控制功能。

小技巧

判断自己服务配置是否成功,可以浏览器访问如下地址。

端口冲突处理

如果配置的端口已被占用,插件将提示你终止占用端口的进程。

请检查是否本地开启了ollama服务,或者其他占用了11434端口的进程。

评论 (0)